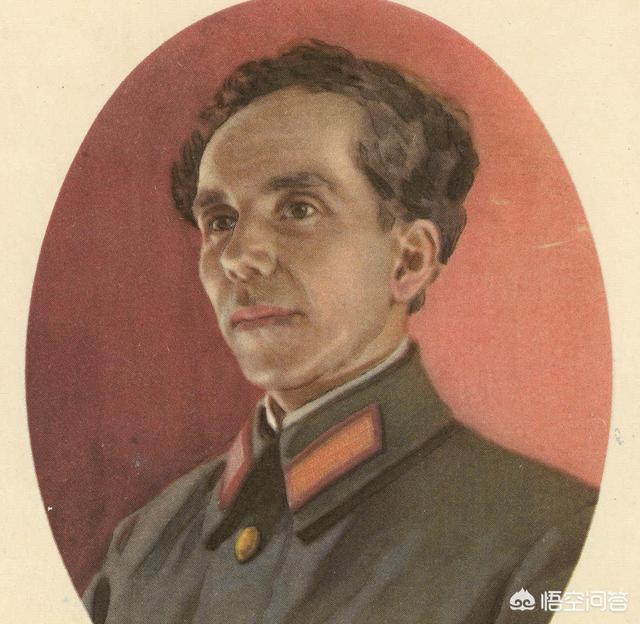

《钢铁是怎样炼成的》作者简介

尼古拉·阿耶克塞耶维奇·奥斯特洛夫斯基生于1904年,逝世于1936年。是苏联无产阶级革命作家,生于乌克兰一个普通工人家庭,12岁开始工作,15岁加入共青团,参加了保卫苏联政权的内战。1920年,他因伤被调到工作岗位。他参与了经济建设的潮流。他负责共青团和党的中下层领导。他是苏联的“优秀共产主义战士”。1935年,他获得了国家最高荣誉列宁勋章,并于1936年逝世。他一生的作品不多,其中最著名的一部是《如何炼钢》。

错误。

长篇小说《钢铁是怎样炼成的》作者是尼古拉.奥斯特洛夫斯基。保尔.柯察金是作者以自己为模型在小说里刻划出的人物形象。我们不仅不能把保尔.柯察金当成尼古拉.奥斯特洛夫斯基,更不能把保尔.柯察金当成小说的原作者。

《钢铁是怎样炼成的》是前苏联作家尼古拉·奥斯特洛夫斯基所著的一部长篇小说,于1933年写成。小说通过记叙保尔·柯察金的成长道路告诉人们,一个人只有在革命的艰难困苦中战胜敌人也战胜自己,只有在把自己的追求和祖国、人民的利益联系在一起的时候,才会创造出奇迹,才会成长为钢铁战士。